コンピュータ科学分野の国際学会(ACM)の分科会「シーグラフアジア2021(SIGGRAPH Asia 2021)」が昨年12月14日から17日までの日程にて、東京国際フォーラム(リアル開催)、及びオンラインのハイブリッドにて開催されました。

只今各発表・展示について順次ご紹介しております。本日からは「E-Tech」のスタートです。

Parallel Ping-Pong(日本・Sony CSL、慶應義塾大学KMD、Project Cybernetic being)

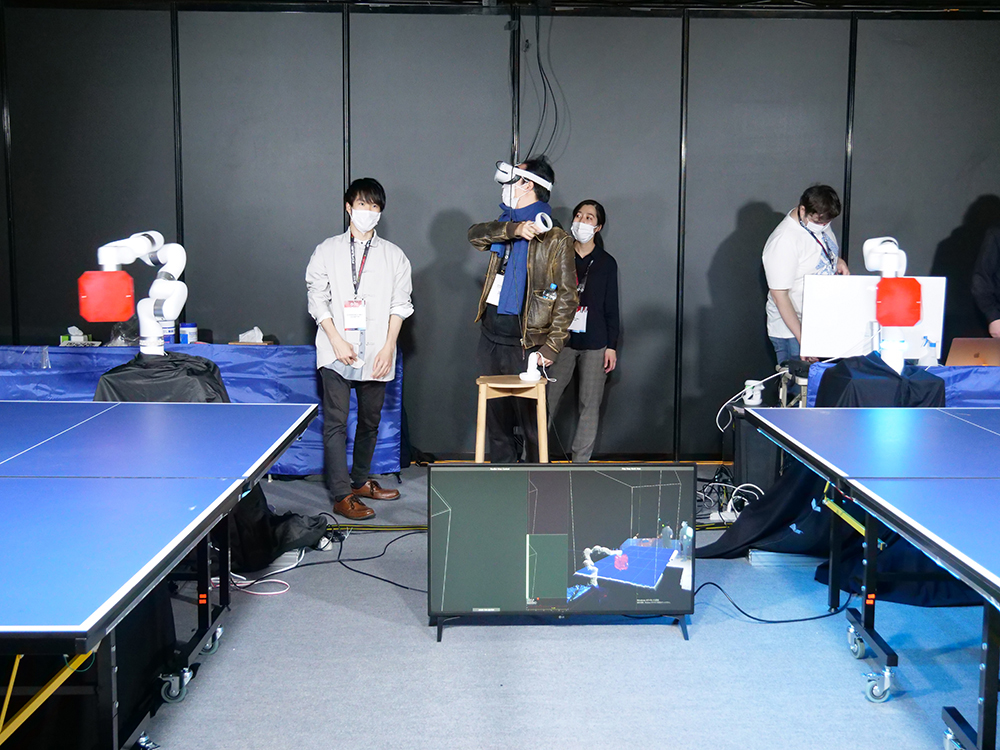

今回のEホール展示で一番目立ち、かつ大盛況だったのがこちらの「パラレル・ピンポン」です。

こちら、科学技術振興機構(JST)のムーンショット支援事業「JST Moonshot Project Cybernetic being」の支援を受け、Sony CSLさんとKMDさんが共同で研究しています。1人のユーザが複数の身体を同時に操作する「パラレル・インタラクション」を探求するための物理的プラットフォームとして開発されたのが、卓球を題材としたこちらです。

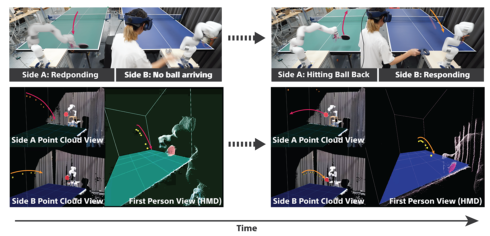

ユーザは2本のロボットアームをVRHMDのコントローラで操作(上記公式映像ではHTC Vive、本展示ではOculus Quest 2のコントローラを使用)し,HMDを通して2台のロボットアームの視点映像を見ながら2つのテーブルで同時に卓球をすることができちゃう! という代物。

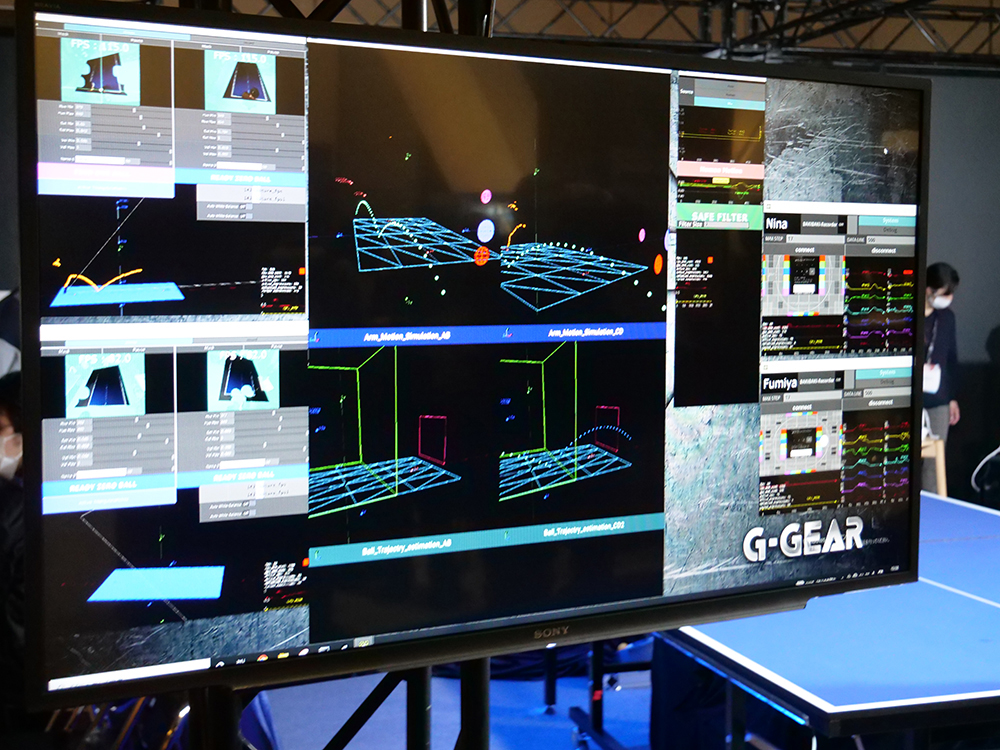

ゲーム状況やピンポン玉の方向や位置に応じて、複数視点映像を分割・合成した映像をHMDに表示することで、2つの視点環境を同時に観測することを可能にしている他、映像やシステムのレイテンシーによって損なわれてしまうロボットアームに対する行為主体性を維持するために、ボールの軌道計算によるロボットアーム自動制御とユーザー自身の動作を統合することで、複数ロボットアームを1人のユーザーが主体性を持ち制御することを実現しているそう。

パラレル・ピンポンは一人のユーザが複数の身体を持ち、並行して身体体験を行うための様々なデザインを検証するためのプラットフォームを目指しているとのことで、これはかなりの応用が効きそう。また、本研究は、Sony CSLの笠原俊一さんによる、コンピュータ技術を用いて人間の感覚に介入したり、人間の知覚を接続することで、工学的に知覚や認知を拡張、変容させる研究の枠組み「Superception(Super + perception)」の一環として研究が行われておりまして、こちらにも期待ですね。

実際に体験させていただいたのですが、HMDではピンポン玉がロボットアームにより近づいてきた方を絶えず優先して表示する仕組みになっていて、かつその映像に合わせて腕を振ると映されたほうのロボットアームだけが同期して動くことで、2人の卓球プレイヤーに一人で相対することができる、という仕組みなんですね。

さらに、ロボットアーム側で軌道演算を行いながら自動的にラケットの位置を補正するので、ちゃんと打ち返せるというのも大きなポイント。なんだか阿修羅像的な力を手に入れたような気分!

これで打ち返したときのフィードバックとかがあると打ち返している感覚が倍増しそう。そもそも映像切替をしているがゆえでしょうか、没入感的な観点は二の次になっている印象でしたが、たしかにこれは非常にわかりやすい「身体拡張感覚」でありました。とにかく行列が途切れることのない、大注目の発表だったと言っても過言ではないでしょう。

Multimodal Feedback Pen Shaped Interface and MR Application with Spatial Reality Display(日本・Sony Interactive Entertainment)

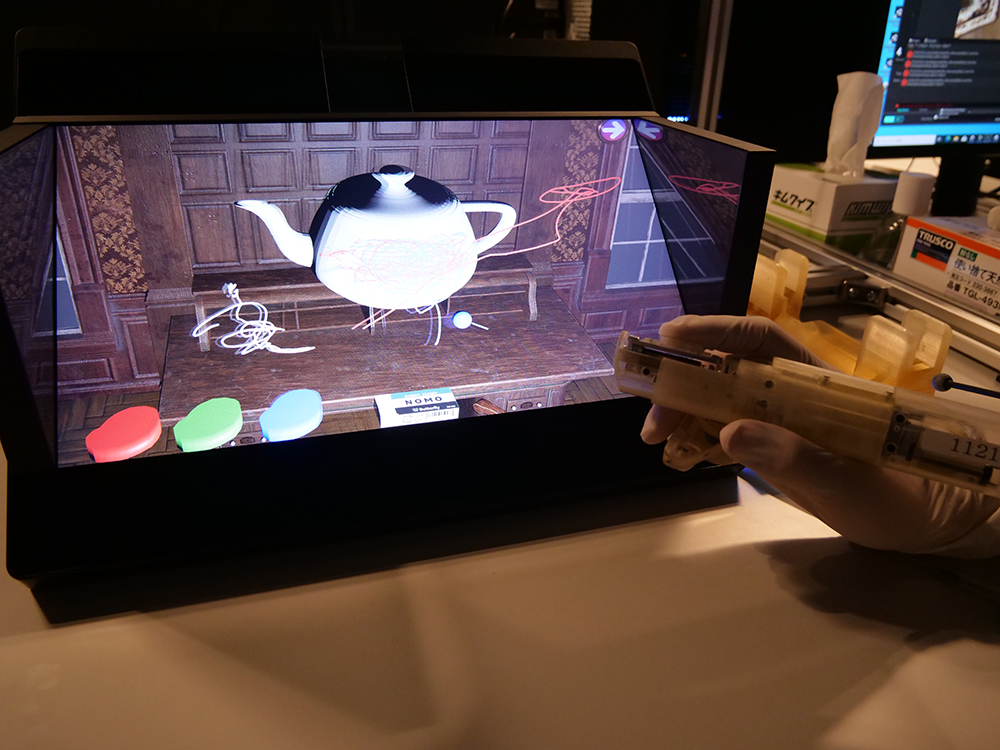

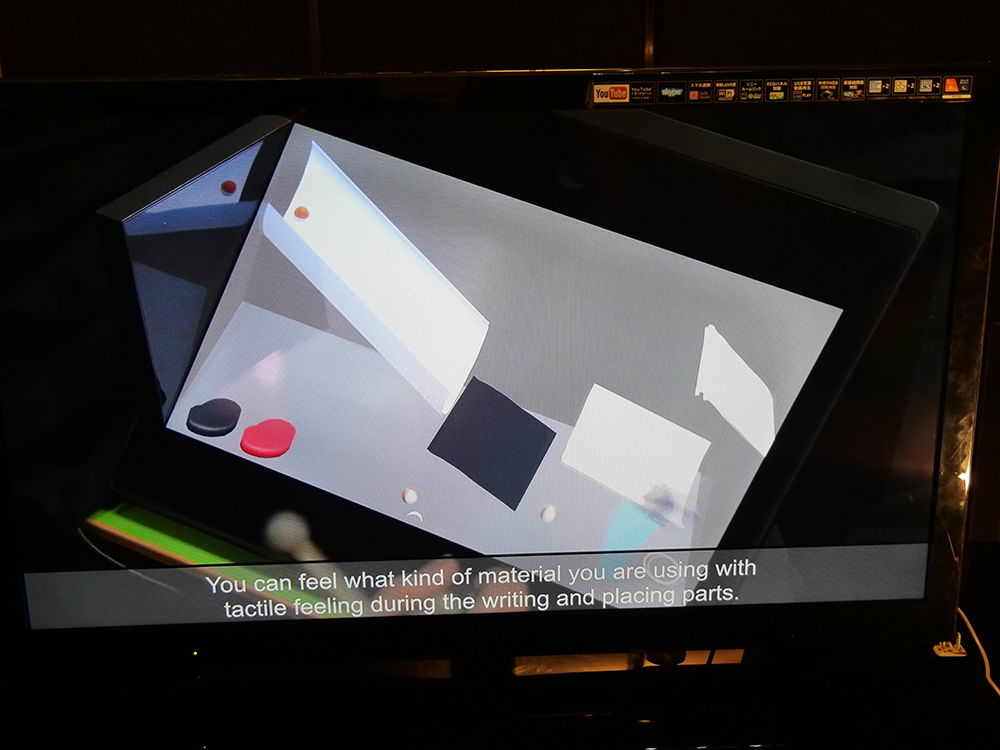

続いてソニーグループからの発表ですが、こちらはSIEさんの研究。ソニーさんがリリースし各所で活用されております空間再現ディスプレイ「ELF-SR1」に表示された3Dオブジェクトに対し、ペン型のデバイスを使用してアプローチするマルチモーダルフィードバック体験であります。

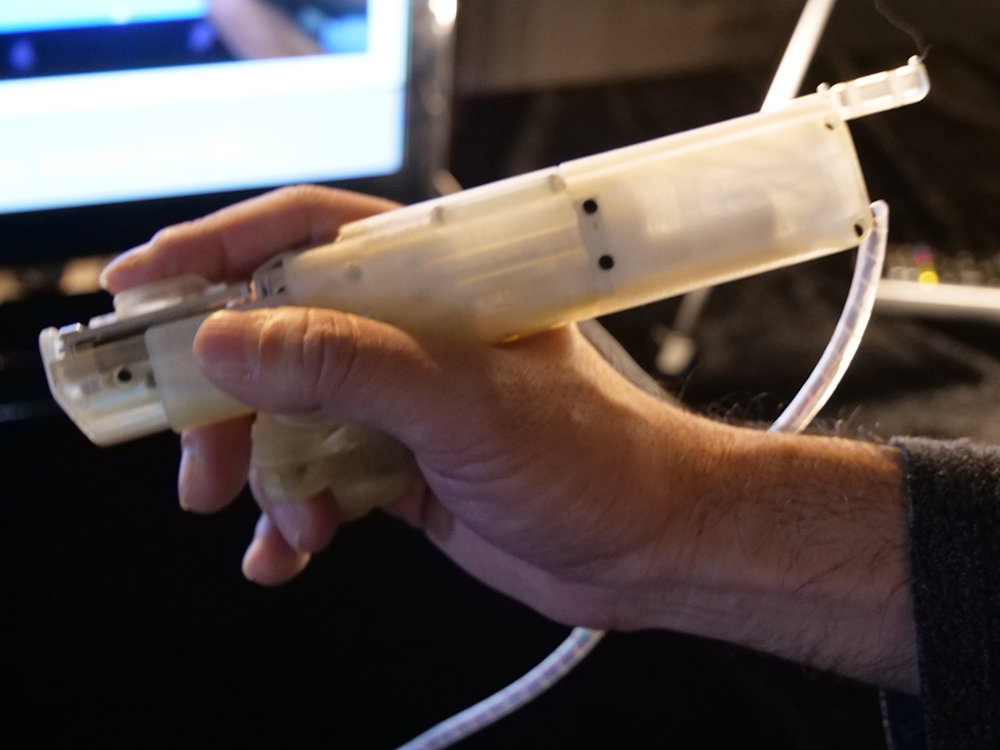

これがそのデバイスのアップ。具体的には……

- ペンが触れた際の接触圧力を表現する線形フィードバック

- ペンが触れた際の「摩擦」「テクスチャ」をシミュレートする回転フィードバック

- 振動触覚フィードバック

を一つのデバイスで表現しよう、という野心的な内容です。上の写真で説明すると、まず親指のところにある端子が前後左右に振動することで、3Dオブジェクトに触れた際の圧力や、ザラザラ感やすべすべ感といった「摩擦」「テクスチャ」的な感覚を表現しており、さらに薬指や小指で握っている部分も同期して振動させることで上記感覚を保管する、という仕組みになっております。

デバイスの位置はマーカーを使ってポジトラを行い、空間表現ディスプレイに浮かんでいる3Dオブジェクトの距離を計測。この位置計算に基づいてデバイスを動かしフィードバックさせている、という塩梅です。

なかなか細やかにチューニングが行われていて非常に面白い感覚でした! 特にテクスチャの感覚掲示が面白かったですね。お話を伺ったところ、感覚掲示についてはデバイスの位置に基づいて予め設定したフィードバックを出力しているとのことですが、これが実際の物理演算をフィードバックするところまで行くと、空間検知デバイスとして非常に興味深い進化を遂げるのではないでしょうか。この先も含め非常に面白い発表でした。

さて、この「E-Tech」には19件の研究が採択されているのですが、実は現在この19件の中から優秀なプレゼンテーションを表彰する「Best Online Demonstration Award」の発表待ちでございます。そちらも分かり次第ご紹介しますので、そちらもお楽しみに! 引き続きE-Techをご紹介してまいります!

取材協力:「シーグラフアジア2021(SIGGRAPH Asia 2021)」運営事務局